Việc xác định quy mô phù hợp và kịp thời bổ sung hạ tầng GPU là một thách thức, tựa như bắn vào một mục tiêu đang di chuyển. Ví dụ, một startup xây dựng nền tảng tạo ảnh AI có thể đối mặt với tình huống lượng yêu cầu tăng đột biến từ 100 lên 10.000 mỗi giờ trong một thời điểm lan truyền mạnh mẽ, buộc họ phải gấp rút cung cấp đủ tài nguyên GPU để tránh dịch vụ ngừng hoạt động. Kể cả khi có sự chuẩn bị, việc sử dụng các công cụ và phương pháp đo lường vẫn tiềm ẩn rủi ro không đạt mục tiêu, dẫn đến tình trạng cung cấp quá nhiều (hoặc quá ít) tài nguyên.

Vậy điều gì sẽ xảy ra nếu một phần của quy trình đó có thể được tự động hóa và yêu cầu ít sự phỏng đoán hơn?

GPU autoscaling cung cấp một giải pháp bằng cách tự động thêm tài nguyên tính toán khi các ngưỡng hoặc số liệu đo lường (metrics) nhất định trong môi trường production của bạn được thỏa mãn. Điều này cho phép hệ thống của bạn cung cấp thêm GPU theo yêu cầu cho các tác vụ AI như suy luận, huấn luyện mô hình và xử lý dữ liệu hàng loạt.

Bài viết này giải thích thời điểm nên sử dụng GPU autoscaling, các lợi ích và thách thức, cùng một số phương pháp tối ưu để giảm thiểu chi phí và độ phức tạp khi sử dụng GPU cho các tác vụ AI.

GPU autoscaling là gì?

GPU autoscaling là quá trình tự động co giãn số lượng và hiệu năng của tài nguyên GPU — tăng lên hoặc giảm xuống — dựa trên nhu cầu sử dụng thực tế của các ứng dụng Trí tuệ nhân tạo (AI).

Giải pháp này phổ biến trong các môi trường điện toán đám mây và container (chẳng hạn như Kubernetes hoặc các nền tảng AI được quản lý) để đảm bảo rằng hệ thống luôn có đủ sức mạnh tính toán khi khối lượng công việc tăng đột biến, và bạn không phải trả thừa chi phí hạ tầng khi mức sử dụng thấp.

Các trường hợp nên sử dụng GPU autoscaling

Có nhiều trường hợp ứng dụng AI đòi hỏi GPU autoscaling để đáp ứng nhu cầu tăng đột biến, hỗ trợ các tập dữ liệu lớn và yêu cầu năng lực tính toán hiệu năng cao:

- Dịch vụ suy luận thời gian thực (Real-time inference): Các ứng dụng loại này thường có mô hình yêu cầu khó đoán và đòi hỏi độ trễ (latency) cực thấp. Việc co giãn GPU giúp đáp ứng các yêu cầu này và tránh lãng phí tài nguyên GPU nhàn rỗi. Ví dụ cụ thể bao gồm chatbot AI tạo sinh (Generative AI), các nền tảng tạo ảnh/video từ văn bản, công cụ dịch thuật và nhận dạng giọng nói AI theo thời gian thực, và các hệ thống gợi ý cá nhân hóa.

- Huấn luyện mô hình quy mô lớn (Large-scale model training): Do kích thước mô hình, các tác vụ này đòi hỏi năng lực tính toán GPU khổng lồ và sẽ hưởng lợi từ việc co giãn tài nguyên linh hoạt. Điều này áp dụng cho việc huấn luyện lại mô hình học máy, tìm kiếm siêu tham số (hyperparameter search), và các môi trường học tăng cường (reinforcement learning).

- Xử lý AI theo lô (Batch AI processing): Mặc dù các tác vụ này không nhất thiết phải chạy liên tục, chúng lại yêu cầu năng lực xử lý cực lớn mỗi khi hoạt động. Có thể kể đến như render/mô phỏng mô hình 3D, phân loại hình ảnh, hoặc xử lý và phân tích video.

- AI tại biên và AI theo sự kiện (Edge and event-driven AI): Việc có sẵn tài nguyên GPU theo yêu cầu giúp cung cấp sức mạnh cho các ứng dụng chỉ kích hoạt hoặc bắt đầu xử lý khi có các sự kiện hoặc tác vụ cụ thể xảy ra. Ví dụ bao gồm hệ thống điều khiển giao thông, phát hiện bất thường trong thiết bị IoT, và phân tích hình ảnh vệ tinh.

Nhìn chung, bạn sẽ cần đến GPU autoscaling ở một mức độ nào đó để xử lý các tập dữ liệu lớn hoặc khi lượng yêu cầu cho ứng dụng AI tăng cao. Tuy nhiên, bạn có thể không cần đến tính năng này nếu khối lượng công việc của bạn luôn ổn định, bạn đang vận hành một ứng dụng kế thừa (legacy) hoặc nguyên khối (monolithic), bạn yêu cầu hiệu năng phải luôn sẵn sàng ở mức cao nhất, hoặc khi việc dự đoán và kiểm soát chi phí một cách cố định là ưu tiên hàng đầu.

Bạn muốn tìm hiểu sâu hơn về GPU autoscaling? Hãy bắt đầu với bài hướng dẫn của DigitalOcean về cách co giãn các workload trên AMD GPU bằng DigitalOcean Kubernetes và KEDA.

Các yếu tố cần cân nhắc khi autoscaling với AI

Mặc dù GPU autoscaling mang lại nhiều lợi ích về chi phí và hiệu suất, việc áp dụng nó cho các tác vụ AI (như inference và training) và các workload production đòi hỏi phải xem xét các yếu tố riêng biệt:

- Tác vụ AI vốn đòi hỏi tài nguyên GPU rất lớn: Kể cả các tác vụ có vẻ đơn giản, ví dụ như một yêu cầu suy luận, cũng có thể tiêu tốn một lượng đáng kể dung lượng GPU. Điều này không chỉ ảnh hưởng đến bài toán chi phí mà còn yêu cầu phải hoạch định kỹ lưỡng để biết chính xác cần bao nhiêu sức mạnh GPU để các tác vụ AI này chạy thành công.

- Autoscaling trở nên phức tạp hơn với các workload AI: Các tác vụ đặc thù này không phải lúc nào cũng chạy liên tục; chúng phụ thuộc vào các mô hình thực thi bất đồng bộ và xử lý dựa trên hàng đợi — nhất là đối với suy luận theo lô (batch inference), các job huấn luyện và chuẩn bị dữ liệu. Điều này dẫn đến sự dao động tài nguyên nhiều hơn và đòi hỏi phải căn cứ vào các số liệu đo lường khác ngoài chỉ số sử dụng GPU hay máy chủ để đáp ứng trọn vẹn nhu cầu tính toán.

- Workload AI thường nhạy cảm với độ trễ, nhưng không đồng nghĩa với thời gian thực: Có những trường hợp sử dụng như trợ lý giọng nói hoặc xe tự hành yêu cầu độ trễ thấp và phản hồi tức thì. Trong khi đó, các tác vụ nền như huấn luyện mô hình hoặc chấm điểm theo lô lại ít nhạy cảm về mặt thời gian hơn, dù vẫn có những yêu cầu riêng về độ trễ. Yếu tố này có thể làm tăng thêm sự phức tạp khi bạn cố gắng cung cấp tài nguyên hoặc thiết lập các workload có autoscaling.

Ngoài các đặc tính này, những yếu tố chuyên sâu hơn ảnh hưởng đến autoscaling cho tác vụ AI còn bao gồm loại GPU, tốc độ đường truyền mạng, các giới hạn (quota) về quyền truy cập tài nguyên, các lớp ảo hóa (virtualization), cũng như thời gian khởi động pod và thời gian tải mô hình AI lên GPU.

Xây dựng bộ công cụ cho GPU autoscaling

Để triển khai GPU autoscaling hiệu quả, bạn cần xây dựng một bộ công cụ đa dạng, không chỉ phụ thuộc vào các chức năng mặc định và tài nguyên GPU sẵn có từ nhà cung cấp đám mây của bạn.

GPU Droplets của DigitalOcean cung cấp khả năng truy cập vào năng lực tính toán GPU theo nhu cầu chỉ bằng một cú nhấp chuột và đã tích hợp sẵn các tính năng autoscaling.

Cấu hình hạ tầng để hỗ trợ autoscaling

Các danh mục công cụ chính bạn cần sử dụng bao gồm Kubernetes, các framework AI/ML, và hệ thống giám sát tùy chỉnh để kích hoạt việc cấp phát tài nguyên.

| Danh mục | Công cụ / Dịch vụ | Phù hợp nhất cho | Tính năng chính |

| Kubernetes | Cluster Autoscaler (CA) | Co giãn các node GPU trong cụm (cluster) | Thêm/xóa các node GPU dựa trên nhu cầu lập lịch của pod. |

| Horizontal Pod Autoscaler (HPA) | Co giãn các pod suy luận (inference) | Co giãn pod dựa trên mức sử dụng GPU hoặc các chỉ số tùy chỉnh (custom metrics). | |

| Vertical Pod Autoscaler (VPA) | Tinh chỉnh (right-sizing) yêu cầu tài nguyên GPU | Điều chỉnh các yêu cầu/giới hạn (requests/limits) GPU cho mỗi pod. | |

| NVIDIA GPU Operator + Device Plugin | Lập lịch và giám sát GPU | Triển khai driver, bật giám sát GPU, tích hợp với các autoscaler. | |

| Kubeflow Training Operators | Huấn luyện AI phân tán | Hỗ trợ autoscaling cho các job TensorFlow, PyTorch, MXNet. | |

| Nền tảng & Công cụ điều phối | Ray Autoscaler | Các workload AI phân tán | Tự động co giãn các node GPU xuyên suốt các cụm/đám mây. |

| NVIDIA Triton Inference Server + KServe | Co giãn suy luận trong môi trường production | Autoscaling suy luận trên nền tảng Kubernetes (Kubernetes-native), hỗ trợ các mô hình đa framework. | |

| MLflow (với tích hợp Kubernetes/Cloud) | Các pipeline thử nghiệm & huấn luyện | Có thể kích hoạt autoscaling thông qua các backend cloud/K8s tích hợp. | |

| Slurm + GPU Scheduling (HPC) | Môi trường nghiên cứu / HPC | Phân bổ GPU dựa trên job, co giãn linh hoạt trong các cụm siêu máy tính. | |

| Giám sát (Monitoring) | Prometheus + Custom Metrics Adapter | Thu thập các chỉ số GPU cho việc autoscaling | Cung cấp chỉ số cho HPA/CA, hoạt động với NVIDIA DCGM exporter. |

| NVIDIA DCGM (Data Center GPU Manager) | Đo lường GPU chi tiết (fine-grained telemetry) | Theo dõi mức sử dụng, bộ nhớ, lỗi và cung cấp dữ liệu cho các autoscaler. | |

| CloudWatch | Các trình kích hoạt co giãn trên nền tảng đám mây (cloud-native) | Tích hợp các chỉ số sử dụng GPU với các chính sách autoscaling. |

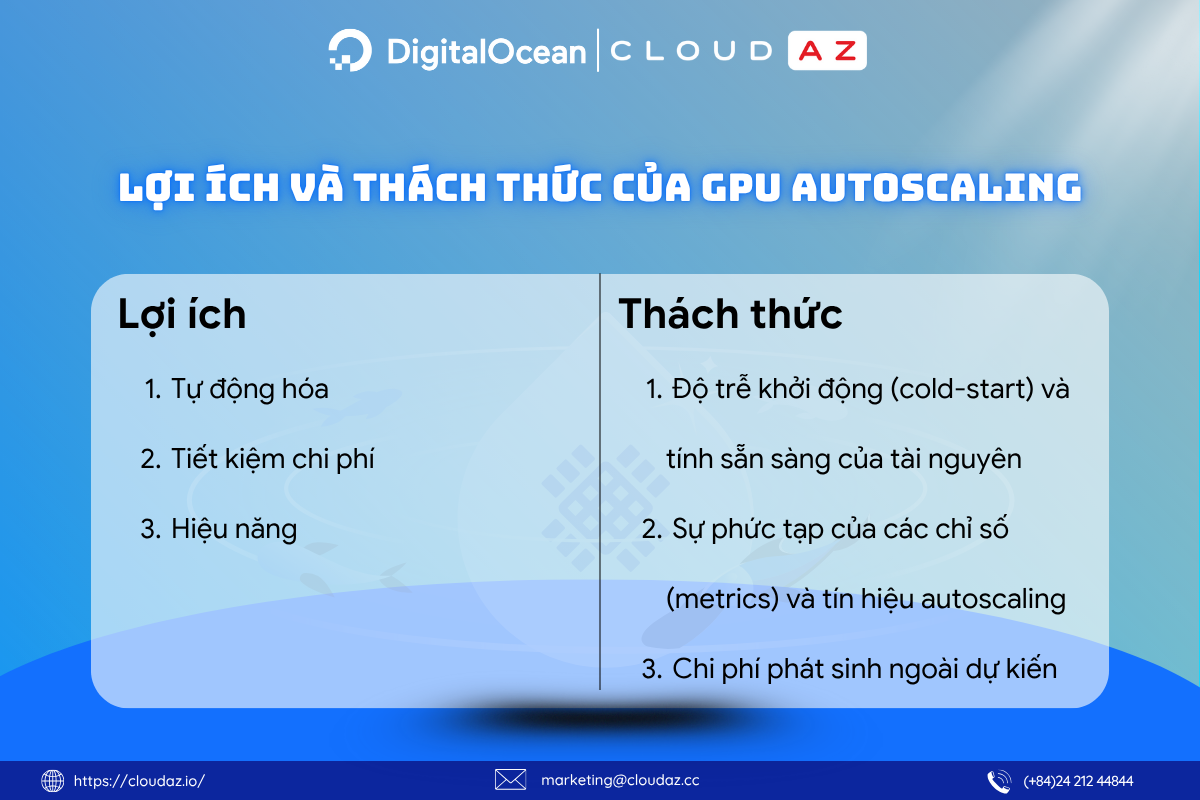

Lợi ích của GPU autoscaling

Mặc dù việc áp dụng autoscaling cho các workload AI có thể phức tạp hơn, phương pháp này vẫn mang lại những lợi ích đặc thù trong việc quản lý tài nguyên tính toán, giúp giảm thiểu đáng kể khối lượng công việc cấp phát và giám sát tài nguyên thủ công.

Tự động hóa

Một phần cốt lõi của việc co giãn tài nguyên tính toán là thiết lập sẵn các ngưỡng (như mức sử dụng GPU hoặc số lượng job trong hàng đợi) để kích hoạt việc cấp phát thêm tài nguyên. Các chính sách được thiết lập sẵn này cho phép tự động hóa mọi tác vụ autoscaling, thay vì phải thêm tài nguyên tính toán GPU một cách thủ công tùy theo yêu cầu của workload. Điều này cho phép hệ thống tự động co giãn mỗi khi cần thiết, thay vì phải cố gắng dự đoán nhu cầu GPU hoặc cấp phát dư thừa tài nguyên một cách không cần thiết.

Tiết kiệm chi phí

Một trong những ưu điểm lớn nhất của autoscaling là tài nguyên có thể tự động tăng giảm tùy theo luồng công việc hoặc các yêu cầu về lưu lượng truy cập cụ thể. Về mặt tài chính, điều này có nghĩa là các doanh nghiệp chỉ phải chi trả cho những tài nguyên tính toán (mạng, xử lý, lưu trữ) khi chúng thực sự được sử dụng. Cách tiếp cận này trái ngược với việc cấp phát một lượng tài nguyên tĩnh và chờ đợi chúng được sử dụng, một phương pháp có thể dẫn đến chi phí bị đội lên.

Hiệu năng

Hiệu năng được tối ưu hóa là yếu tố cần thiết cho các tác vụ AI như suy luận, huấn luyện và triển khai. Việc sử dụng autoscaling để tăng hoặc giảm năng lực GPU sẵn có có thể đảm bảo tài nguyên không bị quá tải khi cần thiết và luôn có đủ năng lực tính toán cho các dịch vụ trực tuyến. Ví dụ, một hệ thống phát hiện gian lận bằng AI có thể đối mặt với lượng giao dịch tăng gấp 10 lần trong ngày Black Friday. Khi đó, hệ thống cần co giãn GPU tức thì để duy trì các cảnh báo gian lận theo thời gian thực trước khi giao dịch được hoàn tất.

Thách thức của GPU autoscaling

Tất nhiên, kích thước của các mô hình AI và lượng dữ liệu khổng lồ cần thiết cho các tác vụ liên quan cũng mang đến một số thách thức nhất định khi triển khai autoscaling:

Độ trễ khởi động (cold-start) và tính sẵn sàng của tài nguyên

Việc khởi tạo các instance GPU mới—đặc biệt cho các tác vụ AI—có thể tốn nhiều thời gian, vì GPU là một tài nguyên mở rộng của Kubernetes và HPA, làm tăng độ phức tạp khi triển khai. Các GPU này cần thời gian để cài đặt driver/plugin CUDA, tải các image, khởi động (warm up) để nạp bộ nhớ đệm (cache), tải trọng số mô hình và biên dịch các engine xử lý. Quá trình này có thể làm tăng tổng độ trễ và ảnh hưởng đến số lượng GPU có thể được khởi tạo trên thực tế, tùy thuộc vào hạn ngạch (quota) của nhà cung cấp đám mây và tính sẵn có của tài nguyên theo từng khu vực.

Sự phức tạp của các chỉ số (metrics) và tín hiệu autoscaling

Do sự phức tạp, số lượng job và lượng dữ liệu mà các workload AI sử dụng, các chỉ số đo lường truyền thống như tỷ lệ yêu cầu hay mức sử dụng bộ nhớ đôi khi không đủ và không phản ánh chính xác tình hình sử dụng GPU hoặc khối lượng các job xử lý theo lô đang tồn đọng. Đối với các job xử lý theo lô lớn trong huấn luyện hoặc suy luận AI, các hệ thống còn phải đối mặt với sự đánh đổi giữa thông lượng (throughput) và độ trễ (latency), đồng thời yêu cầu các chỉ số tùy chỉnh để có thể mở rộng quy mô năng lực tính toán một cách hiệu quả.

Chi phí phát sinh ngoài dự kiến

Mặc dù tiết kiệm chi phí là một lợi ích của autoscaling, mục tiêu này có thể khó đạt được hơn khi làm việc với các workload AI. Nguyên nhân có thể là do bản chất của các workload AI và cách chúng biến động theo thời gian, nhưng không nhất thiết theo một quy luật tuyến tính. Hơn nữa, việc tích hợp xử lý theo lô cho các mô hình sử dụng nhiều dữ liệu cũng khiến việc autoscaling trở nên phức tạp hơn. Ngoài ra, nếu không có sự hoạch định hoặc giám sát phù hợp, tài nguyên GPU có thể đột ngột co giãn ngoài dự kiến khi lưu lượng truy cập hoặc kích thước lô dữ liệu của mô hình tăng vọt.

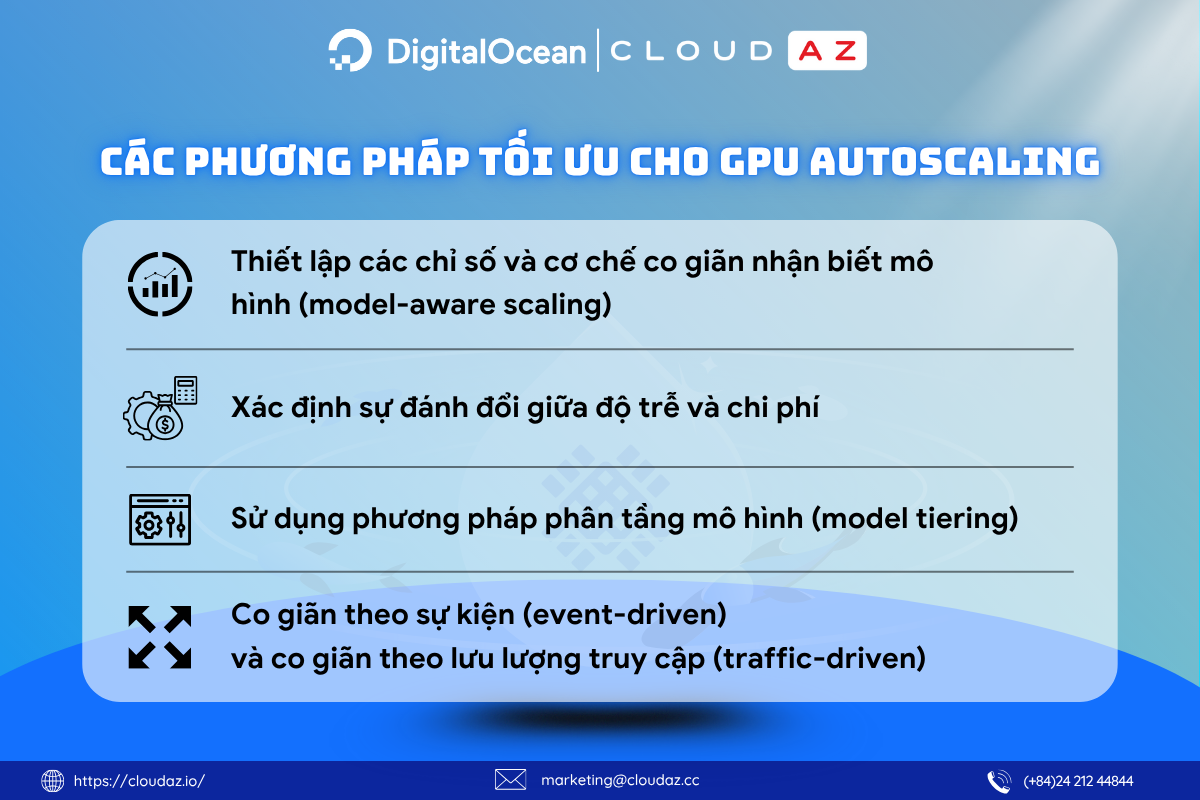

Các phương pháp tối ưu cho GPU autoscaling

Việc áp dụng một số chiến lược sau đây sẽ giúp tạo ra một kế hoạch autoscaling thông minh, hiệu quả và tối ưu chi phí hơn cho các workload AI.

Thiết lập các chỉ số và cơ chế co giãn nhận biết mô hình (model-aware scaling)

Các chỉ số truyền thống (như mức sử dụng GPU hoặc bộ nhớ trống) không phải lúc nào cũng là thước đo chính xác nhất khi thiết lập các giới hạn autoscaling cho AI. Do đó, cần phải xem xét các chỉ số tùy chỉnh hơn, chẳng hạn như chỉ số từ data center GPU manager (DCGM), áp lực bộ nhớ (memory pressure), kích thước lô (batch size), hoặc độ dài hàng đợi (queue length), để xác định các ngưỡng autoscaling.

Một phương pháp khác là sử dụng cơ chế co giãn nhận biết mô hình (model-aware scaling), một kỹ thuật xem xét sự thay đổi về hiệu năng khi các chỉ số ở cấp độ mô hình—như kích thước mô hình, lượng bộ nhớ chiếm dụng (memory footprint), chi phí workload, và mức độ xử lý đồng thời (concurrency)—được co giãn tăng hoặc giảm một cách độc lập. Việc hiểu rõ các chỉ số đặc thù của mô hình ảnh hưởng đến workload autoscaling như thế nào sẽ giúp dự đoán các yêu cầu về hạ tầng và chi phí dễ dàng hơn.

Xác định sự đánh đổi giữa độ trễ và chi phí

Việc xây dựng “ngân sách độ trễ” (latency budgets) cho các tác vụ AI cụ thể cho phép các đội ngũ xác định những dung sai nào có thể được nới lỏng hoặc làm chậm lại để tiết kiệm chi phí hoặc giảm việc sử dụng GPU liên tục. Điều này bao gồm việc phân loại ngân sách cho các tương tác thời gian thực, các dịch vụ chấm điểm và phân loại nội bộ, và các workload xử lý theo lô ngoại tuyến (offline).

Sử dụng phương pháp phân tầng mô hình (model tiering)

Các workload AI có thể được phân loại thành các mô hình: cấp thiết (mission-critical), trung bình (moderate), và thử nghiệm (experimental). Việc phân loại này giúp phân bổ tài nguyên và dành riêng các môi trường chi phí cao cho những workload có tác động lớn hoặc mang tính sống còn.

- Tầng 1 (Tier one): Các mô hình có lưu lượng truy cập cao, nhạy cảm về độ trễ, đòi hỏi GPU chuyên dụng.

- Tầng 2 (Tier two): Các mô hình có tần suất sử dụng trung bình hoặc có thể xử lý theo lô, có thể sử dụng tài nguyên tính toán dùng chung hoặc spot instance.

- Tầng 3 (Tier three): Các workload có độ ưu tiên thấp hoặc mang tính thử nghiệm, có thể sử dụng hàng đợi dùng chung hoặc được lập lịch.

Co giãn theo sự kiện (event-driven) và co giãn theo lưu lượng truy cập (traffic-driven)

Vì nhiều job AI không phải lúc nào cũng bị chi phối bởi lưu lượng truy cập, phương pháp co giãn theo sự kiện (event-driven) có thể hữu ích cho các tác vụ như huấn luyện lại mô hình, chấm điểm dựa trên tệp, suy luận theo lô, và xử lý media. Hệ thống có thể được thiết lập để sử dụng các hàm serverless và các trình chạy job dựa trên hàng đợi (queue-based). Các thành phần này sẽ ở trạng thái chờ cho đến khi một sự kiện cụ thể xảy ra—chẳng hạn như một tập dữ liệu mới được tải lên hoặc một job huấn luyện được lập lịch—thay vì phụ thuộc vào các chỉ số lưu lượng truy cập hay ngưỡng CPU truyền thống.

Tăng tốc các dự án AI của bạn với DigitalOcean Gradient™ GPU Droplets

Đẩy nhanh tiến độ các tác vụ AI/ML, học sâu (deep learning), tính toán hiệu năng cao (HPC) và phân tích dữ liệu với DigitalOcean GradientAI GPU Droplets. Cho phép co giãn theo nhu cầu, quản lý chi phí hiệu quả và dễ dàng mang lại những thông tin chuyên sâu hữu ích.

Sẵn sàng sử dụng GPU chỉ với 2 cú nhấp chuột, thông qua các máy ảo mạnh mẽ và đơn giản được thiết kế cho các nhà phát triển, startup và nhà đổi mới sáng tạo—những người cần sức mạnh tính toán hiệu năng cao mà không đi kèm sự phức tạp.

Đặc điểm nổi bật:

- Được trang bị sức mạnh từ các GPU NVIDIA H100, H200, RTX 6000 Ada, L40S và AMD MI300X.

- Tiết kiệm đến 75% so với các nhà cung cấp đám mây lớn (hyperscalers) cho cùng loại GPU theo nhu cầu.

- Cấu hình linh hoạt, từ thiết lập một GPU đến 8 GPU.

- Được cài đặt sẵn các gói phần mềm Python và Deep Learning.

- Bao gồm ổ đĩa khởi động (boot) và ổ đĩa tạm (scratch) hiệu năng cao tại chỗ.

- Đủ điều kiện HIPAA và tuân thủ SOC 2, đi kèm cam kết chất lượng dịch vụ (SLA) cấp doanh nghiệp.

Đọc thêm: Hướng Dẫn Chọn GPU Droplet: Tối Ưu cho AI/ML 2025

Liên hệ CloudAZ ngay hôm nay để được tư vấn các giải pháp phù hợp với nhu cầu phát triển của doanh nghiệp bạn!