Sự bùng nổ trong phát triển dự án AI đã làm tăng vọt nhu cầu tính toán, thúc đẩy sự cần thiết của các giải pháp phần cứng mạnh mẽ. Ví dụ, một startup phát triển công cụ video AI có thể đặt mục tiêu nâng cấp video độ phân giải thấp lên chất lượng 4K trong thời gian thực. Phần cứng chuyên dụng sẽ giúp thực hiện điều này bằng cách xử lý các mạng nơ-ron phức tạp cần thiết cho việc dự đoán khung hình thông minh và tạo sinh chi tiết ở tốc độ mà CPU truyền thống đơn giản là không thể đạt được. GPU (Bộ xử lý đồ họa) và TPU (Bộ xử lý Tensor) đã nổi lên như những công nghệ thiết yếu để giải quyết các yêu cầu này.

Theo thời gian, GPU đã chuyển đổi từ các chip chuyên dụng chỉ để kết xuất đồ họa trò chơi điện tử thành các bộ xử lý đa năng, có khả năng xử lý hiệu quả các tác vụ phức tạp trong dự án AI nhờ khả năng xử lý song song. Vào năm 2016, Google đã giới thiệu TPU, là các mạch tích hợp chuyên dụng (ASIC) được xây dựng có mục đích, thiết kế riêng cho việc xử lý mạng nơ-ron, nổi bật với phần cứng nhân ma trận chuyên dụng để tăng tốc khối lượng công việc học máy.

Hãy đọc tiếp để khám phá những khác biệt chính giữa hai công nghệ này, hiểu rõ điểm mạnh về kiến trúc của chúng, và tìm hiểu giải pháp nào phù hợp nhất với khối lượng công việc cũng như giới hạn ngân sách cho dự án AI của bạn.

GPU là gì?

GPU (Graphics Processing Unit – Bộ xử lý đồ họa) là một bộ xử lý được thiết kế chuyên biệt để quản lý các tác vụ đồ họa phức tạp và xử lý song song, bao gồm kết xuất hình ảnh và khối lượng công việc trong các dự án AI (AI-ML). Ban đầu, chúng được thiết kế để kết xuất (render) đồ họa 3D phức tạp cho trò chơi điện tử và các ứng dụng hình ảnh.

Tuy nhiên, kiến trúc song song cao của chúng—bao gồm hàng nghìn lõi nhỏ được tối ưu hóa cho các hoạt động đồng thời—lại rất phù hợp cho các phép toán nhân ma trận và vector, vốn là nền tảng của các thuật toán học sâu hiện đại. GPU rất đa năng và hỗ trợ nhiều ứng dụng khác nhau, bao gồm tính toán khoa học, kết xuất đồ họa và xử lý video.

TPU là gì?

Google đã thiết kế TPU (Tensor Processing Unit – Bộ xử lý Tensor) để cung cấp các giải pháp chuyên dụng (purpose-built) cho nhu cầu tính toán của các dự án AI. Không giống như GPU (vốn phát triển từ kết xuất đồ họa sang các ứng dụng AI), TPU được xây dựng ngay từ đầu cho các hoạt động của mạng nơ-ron.

Các bộ xử lý này giúp tăng cường và tối ưu hóa khối lượng công việc trên TensorFlow và JAX cũng như các tác vụ học máy, tập trung chủ yếu vào tính toán AI, phép nhân ma trận và các phép toán tích chập (convolution).

TPU đã liên tục phát triển, với mỗi phiên bản mới đều mang lại những cải tiến và cập nhật đáng kể, giúp việc quản lý khối lượng công việc trở nên hiệu quả. Chúng có sẵn thông qua Nền tảng Google Cloud (Google Cloud Platform) hoặc Google Colab.

TPU vs GPU: Những điểm khác biệt

Cả TPU và GPU đều vượt trội trong việc xử lý khối lượng công việc của dự án AI. Tuy nhiên, sự khác biệt nằm ở cách tiếp cận của chúng để quản lý các khối lượng công việc này và những thách thức liên quan đến các kiến trúc khác nhau, vốn ảnh hưởng đến hiệu suất, đặc điểm và các trường hợp sử dụng của chúng.

Kiến trúc GPU

GPU hoạt động với nguyên tắc cơ bản là song song hóa, nổi bật với hàng nghìn lõi nhỏ được thiết kế để xử lý đồng thời nhiều khối lượng công việc và tác vụ. Một số thành phần cơ bản của kiến trúc này bao gồm:

- Các bộ xử lý đa luồng (Streaming Multiprocessors) với nhiều lõi CUDA

- Các lõi Tensor (Tensor Cores) chuyên dụng để tăng tốc các phép toán ma trận

- Bộ nhớ băng thông cao (HBM) để truy cập dữ liệu nhanh chóng

- Hệ thống phân cấp bộ đệm (cache) phức tạp để quản lý dữ liệu hiệu quả

- Hệ thống quản lý bộ nhớ đa cấp

- Một mô hình lập trình linh hoạt

Tất cả các thành phần này làm cho GPU trở nên rất đa năng, phù hợp cho việc kết xuất đồ họa, xử lý video và hỗ trợ một loạt các ứng dụng cho dự án AI.

Kiến trúc TPU

TPU có kiến trúc chuyên môn hóa cao được tối ưu hóa cho khối lượng công việc học máy trong các dự án AI. Điều này cho phép TPU đạt được hiệu suất và hiệu quả cao để quản lý các khối lượng công việc khác nhau, mặc dù chúng có sự linh hoạt hạn chế hơn so với GPU. Một số thành phần quan trọng trong kiến trúc TPU là:

- Các đơn vị xử lý vector (VPU) để tính toán vector hiệu quả

- Các đơn vị nhân ma trận (Matrix Multiplication Units – MXU) được thiết kế cho các phép toán tensor

- Một mảng kiến trúc systolic (systolic array) để nhân ma trận hiệu quả

- Băng thông bộ nhớ cao được tối ưu cho khối lượng công việc AI

- Tích hợp sâu với framework TensorFlow và JAX của Google

| Tính năng | TPU (Tensor Processing Unit) | GPU (Graphics Processing Unit) |

| Kiến trúc | Bộ tăng tốc AI chuyên dụng với kiến trúc mảng systolic (systolic array). | Bộ xử lý song song đa dụng với hàng nghìn lõi. |

| Độ linh hoạt | Hạn chế – Được tối ưu hóa chủ yếu cho TensorFlow. | Cao – Hỗ trợ nhiều framework và ứng dụng. |

| Hiệu suất | Xuất sắc cho xử lý hàng loạt (batch processing), vượt trội cho các mô hình TensorFlow cụ thể. | Hiệu suất cao với các thư viện được tối ưu hóa, phù hợp với nhiều loại mô hình. |

| Tính khả dụng | Có sẵn thông qua Google Colab hoặc Google Cloud. | Phổ biến rộng rãi, có thể mua (phần cứng) hoặc thuê qua đám mây. |

| Khả năng mở rộng | Thiết kế để mở rộng dựa trên pod (pod-based) cho các workflow (quy trình) của dự án AI lớn. | Mở rộng tốt với các thiết lập đa GPU (multi-GPU). |

| Băng thông bộ nhớ | Lên đến 2.5TB/giây với TPU v4. | Lên đến 2TB/giây với H100. |

| Hiệu quả năng lượng | Được thiết kế để tối ưu hiệu quả cho trung tâm dữ liệu. | Đang được cải thiện qua các thế hệ mới. |

| Chi phí | $1.35 – $5 mỗi giờ, tùy thuộc vào phiên bản. | DigitalOcean GPU Droplet bắt đầu từ $1.99/GPU/giờ. |

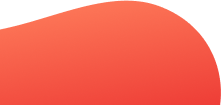

Các trường hợp sử dụng GPU

GPU đã trở nên thiết yếu cho các doanh nghiệp trong lĩnh vực phát triển dự án AI trên nhiều ngành công nghiệp, nhờ vào tính linh hoạt và sự sẵn có rộng rãi của chúng. Dưới đây là một số trường hợp sử dụng GPU phổ biến nhất:

GPU đã trở nên thiết yếu cho các doanh nghiệp trong lĩnh vực phát triển dự án AI trên nhiều ngành công nghiệp, nhờ vào tính linh hoạt và sự sẵn có rộng rãi của chúng. Dưới đây là một số trường hợp sử dụng GPU phổ biến nhất:

Cloud Gaming

GPU ban đầu được thiết kế để kết xuất (render) hình ảnh 3D phức tạp trong thời gian thực và vượt trội trong việc xử lý dữ liệu hình ảnh song song. Chúng mang lại trải nghiệm chơi game mượt mà với tốc độ khung hình cao và hiệu ứng ánh sáng chân thực. Các công cụ (engine) game ngày nay phụ thuộc rất nhiều vào khả năng của GPU cho các tính năng bổ sung như dò tia (ray tracing), mô phỏng vật lý, và kết xuất môi trường thế giới mở với độ trễ (latency) tối thiểu.

Học sâu và Huấn luyện mô hình AI

GPU mang lại sự đa dụng cho việc phát triển dự án AI trên nhiều framework (PyTorch, TensorFlow và JAX). Nhờ các tính năng của mình, bao gồm sự sẵn có rộng rãi trong các hệ sinh thái phần mềm hoàn thiện, GPU là lựa chọn mặc định cho hầu hết các ngành và các nhà nghiên cứu AI. Chúng cũng hỗ trợ các định dạng độ chính xác (precision) khác nhau, bao gồm FP32, FP16 và INT8, mang đến sự linh hoạt trong việc tối ưu hóa quá trình huấn luyện và suy luận.

Kết xuất hoạt ảnh 3D

GPU được sử dụng trong các ngành công nghiệp điện ảnh, giáo dục, kiến trúc, game và quảng cáo để tăng tốc thời gian kết xuất hoạt ảnh và hình ảnh. Việc xử lý hiệu ứng, chỉnh màu (color grading), tua nhanh (timeline scrubbing) và các hoạt động xuất file (exporting) đều được hưởng lợi từ khả năng tăng tốc của GPU. Đối với kết xuất hoạt ảnh 3D, GPU giảm thời gian render, đặc biệt là đối với các cảnh phức tạp có ánh sáng, họa tiết (textures) và hiệu ứng hạt (particle effects) nâng cao.

Nghiên cứu tính toán

GPU tăng tốc các mô phỏng phức tạp trong các ngành như mô hình hóa thiên văn, động lực học phân tử, động lực học chất lỏng và dự báo thời tiết. Khả năng xử lý song song cho phép xử lý hiệu quả các bộ dữ liệu khổng lồ và chạy mô phỏng hiệu quả. Các tổ chức nghiên cứu tận dụng các cụm GPU (GPU clusters) để giải quyết các vấn đề đòi hỏi tính toán cường độ cao mà các hệ thống CPU truyền thống phải mất hàng tháng hoặc hàng năm, tạo ra các đột phá trong khoa học khí hậu và phát triển dược phẩm.

Các ứng dụng thị giác máy tính

Nhờ kiến trúc của mình, GPU cung cấp sức mạnh cho các hệ thống phát hiện vật thể thời gian thực, phân tích video, nhận dạng khuôn mặt và lái xe tự hành. Chúng rất phù hợp cho các phép toán ma trận cần thiết để xử lý dữ liệu hình ảnh thông qua các mạng nơ-ron tích chập (CNN). Các thiết bị điện toán biên (Edge computing) thường tích hợp GPU để cho phép xử lý thị giác máy tính ngay trên thiết bị mà không cần phụ thuộc vào đám mây.

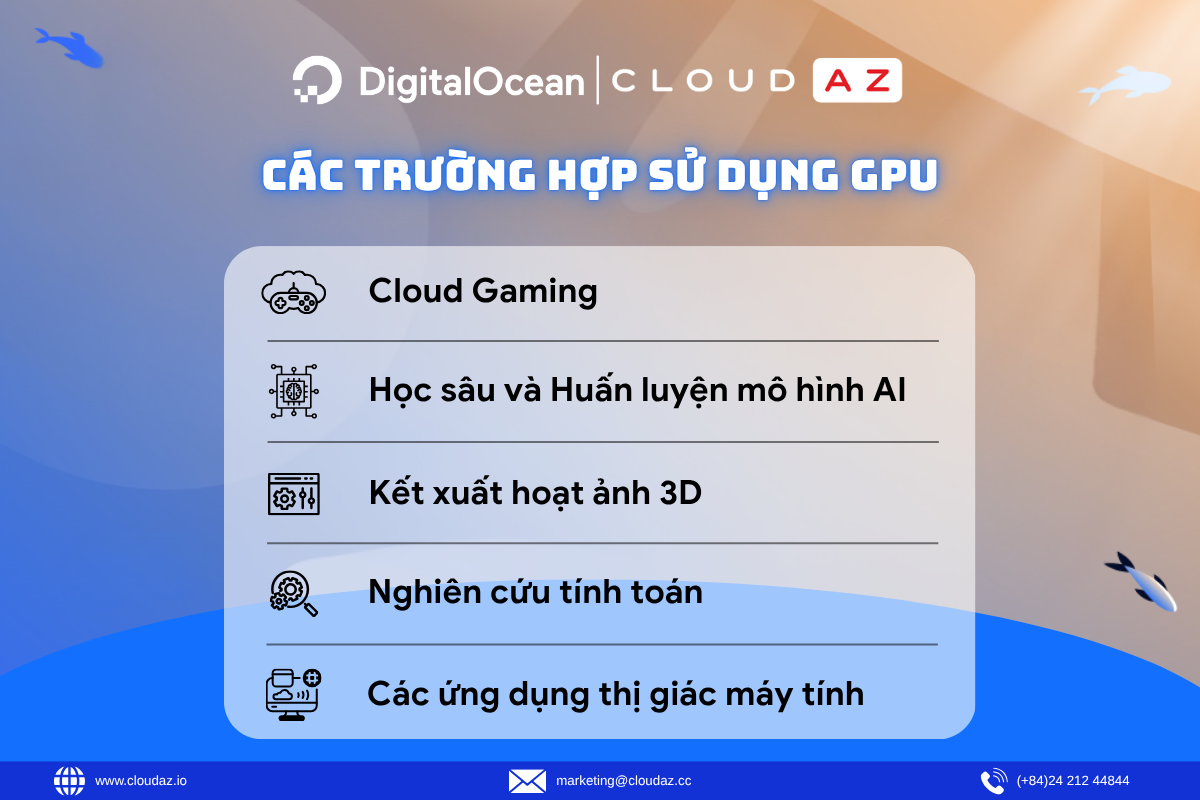

Các trường hợp sử dụng TPU

TPU mang tính chuyên dụng cao hơn và cung cấp hiệu suất vượt trội cho các tác vụ học máy (machine learning) cụ thể trong các dự án AI, đặc biệt là trong hệ sinh thái của Google. Dưới đây là một số trường hợp sử dụng TPU phổ biến:

Nhận dạng và phân loại hình ảnh

Kiến trúc của TPU được tối ưu hóa cho các phép toán tensor, khiến chúng rất hiệu quả cho các mô hình thị giác máy tính trong các dự án AI xử lý bộ dữ liệu lớn. Các lĩnh vực như hình ảnh vệ tinh, chẩn đoán hình ảnh y tế và hệ thống kiểm kê bán lẻ sử dụng TPU để huấn luyện trên hàng triệu hình ảnh với thông lượng (throughput) cao. TPU cũng có mô hình thực thi xác định (deterministic), mang lại lợi ích về tính nhất quán cho các ứng dụng trong ngành chịu quản lý nghiêm ngặt (regulated applications), vốn đòi hỏi kết quả có thể tái tạo (reproducible).

Các hệ thống gợi ý (Recommendation systems)

Các nền tảng trực tuyến có thể sử dụng TPU để cung cấp sức mạnh cho các dự án AI về gợi ý (recommendation engines) nhằm xử lý hàng tỷ tương tác của người dùng. Các bộ máy này cũng xử lý các ma trận thưa (sparse matrices), nhiều chiều (high-dimensional) vốn là tiêu chuẩn trong các hệ thống lọc cộng tác (collaborative filtering) và gợi ý dựa trên embedding. Băng thông bộ nhớ cao hỗ trợ xử lý hiệu quả các tra cứu embedding (embedding lookups).

Huấn luyện mô hình ngôn ngữ lớn (LLM)

TPU cung cấp sức mạnh tính toán cần thiết cho các dự án AI phức tạp nhất, như các mô hình ngôn ngữ lớn (LLM) có hàng tỷ tham số. Các tổ chức làm việc với các mô hình nền tảng (foundation models) hưởng lợi từ việc sử dụng TPU nhờ khả năng xử lý hiệu quả các cơ chế chú ý (attention mechanisms) và các phép toán transformer khác. Các mô hình ngôn ngữ cụ thể của Google, bao gồm BERT, T5 và PaLM, đều đang sử dụng cơ sở hạ tầng TPU.

Nghiên cứu dựa trên TensorFlow

Các nhóm nghiên cứu học thuật và công nghiệp sử dụng TPU để tăng tốc các chu kỳ thử nghiệm trong các dự án AI của họ khi làm việc với các mô hình TensorFlow. Trình biên dịch XLA (Đại số tuyến tính tăng tốc) tối ưu hóa các phép toán dành riêng cho phần cứng TPU. Các lĩnh vực nghiên cứu như mô hình tạo sinh (generative models), học tăng cường (reinforcement learning) và AI đa phương thức (multimodal AI) hưởng lợi từ hiệu quả tính toán của TPU cho các thí nghiệm quy mô lớn.

Huấn luyện Machine Learning (ML) trên Google Cloud

TPU trên Google Cloud giúp tăng tốc việc huấn luyện cho các dự án AI (ML) bằng phần cứng chuyên dụng được tối ưu hóa cho khối lượng công việc học sâu. Chúng vượt trội trong các phép toán ma trận theo yêu cầu của các framework như TensorFlow và JAX, cho phép huấn luyện hiệu quả các mạng nơ-ron phức tạp. Cloud TPU cung cấp quyền truy cập theo yêu cầu vào hệ thống tính toán hiệu năng cao mà không cần đầu tư phần cứng, cho phép các tổ chức mở rộng các tác vụ huấn luyện (training jobs) trên nhiều chip được kết nối với nhau để có kết quả nhanh hơn.

Tăng tốc các dự án AI với DigitalOcean Gradient GPU Droplets

Tăng tốc các tác vụ AI/ML, học sâu (deep learning), tính toán hiệu năng cao (HPC) và phân tích dữ liệu của bạn với DigitalOcean Gradient GPU Droplets. Mở rộng quy mô theo nhu cầu, quản lý chi phí và cung cấp thông tin chuyên sâu (insights) hữu ích một cách dễ dàng.

Sẵn sàng GPU chỉ trong 2 cú nhấp chuột với các máy ảo (virtual machines) đơn giản nhưng mạnh mẽ, được thiết kế cho các nhà phát triển, startup và nhà đổi mới, những người cần tính toán hiệu năng cao mà không rắc rối.

Các tính năng chính:

- Được trang bị GPU NVIDIA H100, H200, RTX 6000 Ada, L40S và AMD MI300X.

- Tiết kiệm đến 75% so với các nhà cung cấp đám mây siêu lớn (hyperscalers) cho cùng loại GPU theo yêu cầu.

- Cấu hình linh hoạt, từ thiết lập một GPU (single-GPU) đến 8 GPU.

- Cài đặt sẵn các gói phần mềm Python và Học sâu.

- Đã bao gồm ổ đĩa khởi động (boot) và ổ đĩa nháp (scratch) cục bộ hiệu suất cao.

- Đủ điều kiện HIPAA và tuân thủ SOC 2, đi kèm Cam kết chất lượng dịch vụ (SLA) cấp doanh nghiệp.

👉Liên hệ với đội ngũ chuyên gia của CloudAZ ngay hôm nay để nhận tư vấn và khám phá giải pháp đám mây phù hợp nhất cho doanh nghiệp của bạn!