Nhu cầu tính toán trong kỷ nguyên hiện đại đã tăng trưởng với tốc độ chưa từng có. Ví dụ, tài nguyên tính toán cần thiết để huấn luyện Minerva (một hệ thống AI có khả năng giải quyết các vấn đề toán học tiên tiến) gần như gấp sáu triệu lần so với tài nguyên dùng để huấn luyện AlexNet một thập kỷ trước. Dù là huấn luyện các mô hình artificial intelligence (AI) tiên tiến hay kết xuất các hiệu ứng hình ảnh phức tạp, một GPU đơn lẻ đơn giản là không còn khả năng đáp ứng.

Đây là lúc giải pháp multi-GPU computing trở nên thiết yếu.

Các công ty công nghệ hàng đầu như Meta hiện sử dụng các cụm hàng nghìn GPU để huấn luyện các mô hình ngôn ngữ lớn (large language models), trong khi các studio như Pixar tận dụng các mảng GPU khổng lồ để mang lại sự sống động cho các thế giới hoạt hình. Đối với các nhà phát triển và doanh nghiệp đang tận dụng machine learning, AI, hoặc các ứng dụng đòi hỏi đồ họa chuyên sâu, việc tìm hiểu và sử dụng các giải pháp multi-GPU computing là chìa khóa để duy trì lợi thế cạnh tranh.

Bài viết này sẽ giải thích mọi khía cạnh quan trọng về multi-GPU computing, giúp bạn hiểu rõ cách tăng tốc các khối lượng công việc và tối ưu hóa hiệu suất ở quy mô lớn.

Multi-GPU Computing là gì?

Multi-GPU computing là một thiết lập phần cứng sử dụng nhiều đơn vị xử lý đồ họa (GPUs) cùng lúc để xử lý các tác vụ tính toán phức tạp.

Phương pháp xử lý song song này phân phối khối lượng công việc trên hai hoặc nhiều GPU để đồng thời xử lý các phần khác nhau của cùng một tác vụ. Các hệ thống multi-GPU được thiết kế để phân chia công việc, qua đó đạt được thời gian xử lý nhanh hơn và có khả năng xử lý các tập dữ liệu lớn hơn nhiều.

Các cấu hình Multi-GPU Computing phổ biến

Một hệ thống multi-GPU computing có thể được thiết lập với nhiều cấu hình khác nhau. Mỗi loại được thiết kế cho các trường hợp sử dụng và yêu cầu hiệu suất cụ thể, phụ thuộc vào các yếu tố như loại workload, khả năng mở rộng và ngân sách.

- Single-system multi-GPU: Nhiều GPU được cài đặt trong một máy trạm, kết nối thông qua bo mạch chủ. Đây là thiết lập phổ biến cho các nhà phát triển cá nhân và nhóm nhỏ.

- Direct GPU-to-GPU connection: Các GPU giao tiếp trực tiếp qua các kết nối liên thông tốc độ cao như NVIDIA NVLink hoặc AMD Infinity Fabric, giúp giảm thiểu độ trễ và tối đa hóa băng thông.

- Network-based GPU clusters: Nhiều máy tính (mỗi máy có một hoặc nhiều GPU) được kết nối qua mạng tốc độ cao. Cấu hình multi-GPU computing này thường được sử dụng trong các trung tâm dữ liệu và môi trường cloud.

- Distributed multi-GPU systems: Các GPU được phân tán ở các vị trí địa lý khác nhau nhưng làm việc cùng nhau thông qua phần mềm chuyên dụng.

- Hybrid GPU configurations: Sự kết hợp của các loại GPU khác nhau làm việc cùng nhau (ví dụ: kết hợp GPU cấp tiêu dùng và cấp chuyên nghiệp).

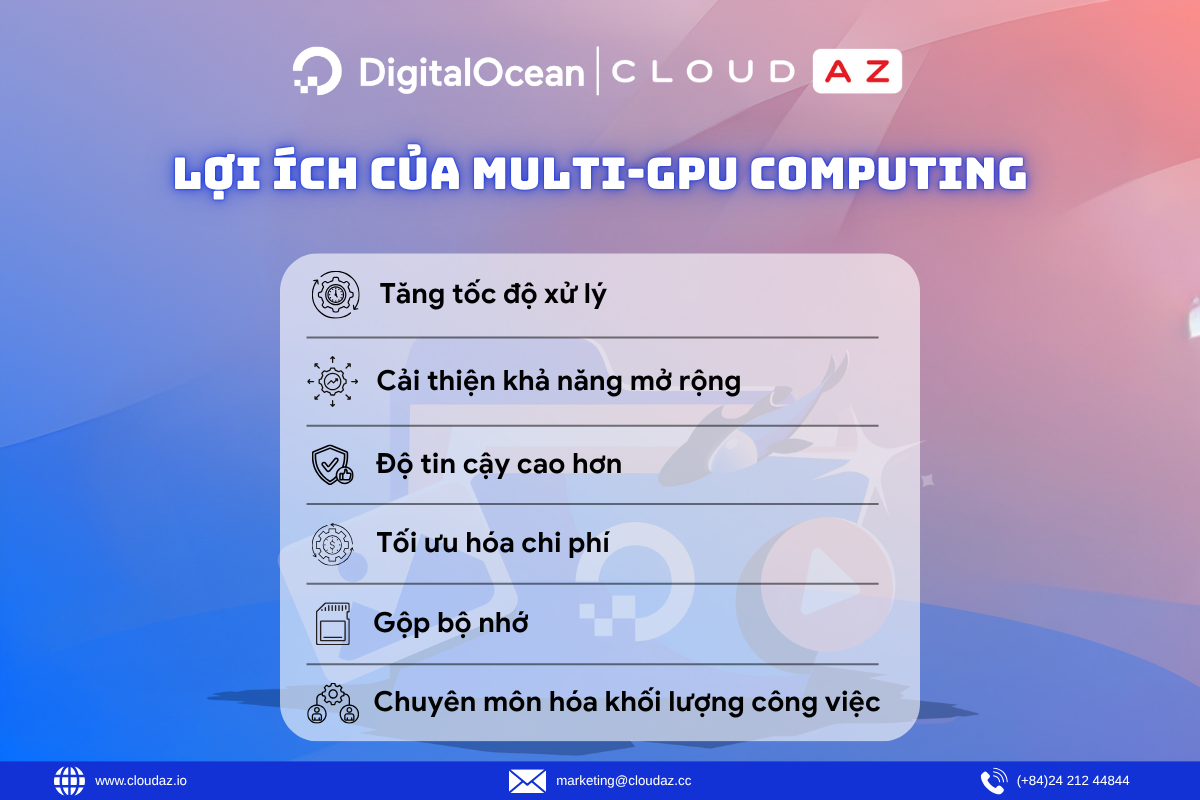

Lợi ích của Multi-GPU Computing

Việc đầu tư ban đầu vào các hệ thống multi-GPU có thể là một rào cản, nhưng lợi ích về hiệu suất mà multi-GPU computing mang lại thường xứng đáng với chi phí, đặc biệt đối với các tác vụ tính toán chuyên sâu.

- Tăng tốc độ xử lý: Đây là lợi ích lớn nhất của multi-GPU computing. Các tác vụ có thể mất nhiều ngày trên một GPU đơn lẻ có thể được hoàn thành trong vài giờ.

- Cải thiện khả năng mở rộng: Các tổ chức có thể bắt đầu với cấu hình multi-GPU nhỏ và thêm nhiều đơn vị hơn khi nhu cầu tăng lên.

- Độ tin cậy cao hơn: Trong một hệ thống multi-GPU, nếu một GPU gặp sự cố, các GPU khác vẫn có thể tiếp tục hoạt động, giảm nguy cơ hỏng hóc toàn bộ hệ thống.

- Tối ưu hóa chi phí: Về lâu dài, các hệ thống multi-GPU thường hiệu quả về chi phí hơn so với việc liên tục nâng cấp lên mẫu GPU đơn lẻ mới nhất và mạnh nhất.

- Gộp bộ nhớ: Cho phép xử lý các datasets và mô hình AI cực lớn mà không thể vừa vặn trong bộ nhớ của một GPU đơn lẻ.

- Chuyên môn hóa khối lượng công việc: Các GPU khác nhau trong hệ thống có thể được tối ưu hóa cho các tác vụ cụ thể (ví dụ: một GPU xử lý AI inference, một GPU khác xử lý visualization).

Multi-GPU Computing hoạt động như thế nào?

Các tác vụ chuyên sâu về GPU hiện đại thường vượt quá khả năng của một card đồ họa. Các hệ thống multi-GPU computing vượt qua thách thức này thông qua bốn quy trình chính hoạt động đồng bộ.

1. Kết nối phần cứng:

Tốc độ di chuyển dữ liệu giữa các GPU là tối quan trọng. Thay vì chỉ dùng kết nối PCIe (Peripheral Component Interconnect Express) truyền thống, các hệ thống multi-GPU hiện đại sử dụng các kết nối chuyên dụng như NVIDIA NVLink hoặc AMD Infinity Fabric. Các đường dẫn tốc độ cao này cho phép các GPU chia sẻ dữ liệu trực tiếp, giảm thiểu thời gian chờ.

2. Quản lý bộ nhớ:

Hệ thống multi-GPU xử lý dữ liệu theo hai cách chính:

- Independent memory (Bộ nhớ độc lập): Mỗi GPU duy trì không gian bộ nhớ riêng và chia sẻ các bản cập nhật khi cần.

- Shared memory (Bộ nhớ chia sẻ): Các cấu hình khác sử dụng bộ nhớ hợp nhất (unified memory), nơi tất cả các GPU truy cập vào một vùng nhớ chung (shared pool).

3. Phân phối khối lượng công việc:

Các framework phần mềm chịu trách nhiệm phân chia công việc phức tạp giữa các GPU. Khi một quy trình bắt đầu, các framework này sẽ phân tích tác vụ, chia nhỏ nó và phân phối dựa trên các yếu tố như workload hiện tại, dung lượng bộ nhớ và khả năng xử lý của mỗi GPU để duy trì hiệu suất tối ưu.

4. Đồng bộ hóa:

Để giữ cho nhiều GPU hoạt động đồng điệu đòi hỏi sự định thời chính xác. Hệ thống multi-GPU computing liên tục giám sát hoạt động, quản lý các sự phụ thuộcgiữa các tác vụ và xử lý mọi sự cố xảy ra. Sự điều phối này ngăn ngừa các điểm nghẽn.

Ứng dụng thực tế của Multi-GPU Computing

Khởi đầu trong nghiên cứu khoa học và rendering đồ họa, ngày nay multi-GPU computing cung cấp sức mạnh cho mọi lĩnh vực, từ phát triển AI đến mô hình hóa tài chính.

Phát triển Machine Learning và AI

Huấn luyện các mô hình AI phức tạp đòi hỏi sức mạnh tính toán khổng lồ. Các công ty như OpenAI và DeepMind sử dụng các hệ thống multi-GPU để huấn luyện large language models và các hệ thống thị giác máy tính, giảm thời gian huấn luyện từ vài tuần xuống còn vài ngày.

Đọc thêm: GPU Autoscaling Cho AI: Từ Thiết Lập Đến Tối Ưu Hóa Chi Phí

Nghiên cứu khoa học

Các tổ chức nghiên cứu sử dụng multi-GPU computing cho các mô phỏng phức tạp trong các lĩnh vực như mô hình hóa khí hậu, động lực học phân tử và vật lý hạt.

Kết xuất 3D và Trực quan hóa

Các studio chuyên về hiệu ứng hình ảnh và các công ty kiến trúc dựa vào hệ thống multi-GPU để render các cảnh 3D và hoạt ảnh phức tạp, phân phối workload trên nhiều GPU để tăng tốc độ sản xuất thay vì chờ đợi hàng giờ cho một frame duy nhất.

Mô hình hóa tài chính

Các tổ chức tài chính sử dụng hệ thống multi-GPU để chạy các phân tích rủi ro và thuật toán giao dịch, cho phép họ xử lý dữ liệu thị trường theo thời gian thực và đưa ra quyết định nhanh hơn.

Phân tích dữ liệu

Từ việc phân tích mẫu hành vi khách hàng đến xử lý dữ liệu cảm biến IoT, các hệ thống multi-GPU giúp các doanh nghiệp trích xuất thông tin chi tiết nhanh hơn để đưa ra quyết định dựa trên dữ liệu.

Tăng tốc Dự án AI/ML của Bạn với DigitalOcean Gradient GPU Droplets

Bạn đang tìm kiếm giải pháp tối ưu cho các tác vụ AI/ML, học sâu, tính toán hiệu năng cao, và phân tích dữ liệu? Hãy khám phá DigitalOcean Gradient GPU Droplets – nền tảng lý tưởng để khai thác sức mạnh của Multi-GPU Computing mà không cần phức tạp.

Với Gradient GPU Droplets, bạn có thể tăng tốc các dự án của mình và mở khóa những hiểu biết sâu sắc. Chỉ cần 2 cú nhấp chuột đơn giản, bạn đã có ngay một máy ảo mạnh mẽ được thiết kế cho các nhà phát triển, startup và nhà đổi mới:

- Hiệu năng vượt trội: Được trang bị các GPU hàng đầu như NVIDIA H100, H200, RTX 6000 Ada, L40S, và AMD MI300X.

- Tiết kiệm chi phí: Tiết kiệm đến 75% so với các hyperscaler cho cùng loại GPU theo yêu cầu.

- Cấu hình linh hoạt: Dễ dàng mở rộng từ một GPU đơn lẻ lên đến các thiết lập Multi-GPU Computing 8-GPU.

- Sẵn sàng sử dụng: Đi kèm với các gói phần mềm Python và Deep Learning được cài đặt sẵn.

- Đảm bảo tuân thủ: Đủ điều kiện HIPAA và tuân thủ SOC 2 với SLA cấp độ doanh nghiệp.

Đăng ký ngay hôm nay để trải nghiệm sự khác biệt của DigitalOcean Gradient GPU Droplets và đưa các khối lượng công việc AI/ML đòi hỏi khắt khe nhất của bạn lên một tầm cao mới!

Đọc thêm: GPU Observability – Hiểu Sâu Hơn Về Droplets và DOKS Clusters