Các công ty mong muốn tích hợp khả năng Trí tuệ Nhân tạo/Học máy (AI/ML) từ trước đến nay thường phải đối mặt với nhu cầu về GPU tại chỗ, kéo theo chi phí mua phần cứng đắt đỏ, đội ngũ IT chuyên môn cao, và quản lý cơ sở hạ tầng phức tạp. Ngay cả khi sử dụng GPU đám mây, các tổ chức vẫn thường phải tự mình giải quyết một số tác vụ như chọn loại phiên bản, cài đặt phần mềm, cấu hình môi trường và thực hiện điều chỉnh quy mô thủ công.

Kiến trúc Serverless đã xuất hiện như một giải pháp để chạy các ứng dụng và dịch vụ mà không cần quản lý cơ sở hạ tầng thực tế—nhà cung cấp dịch vụ đám mây sẽ đảm nhận mọi thứ. Các nền tảng Serverless GPU, được xây dựng trên nền tảng GPU đám mây, cho phép người dùng truy cập sức mạnh GPU khi cần, thanh toán theo mức sử dụng, và loại bỏ gánh nặng duy trì toàn bộ cơ sở hạ tầng nền tảng. Vậy, các tổ chức có thể tận dụng những nền tảng Serverless GPU này cho khối lượng công việc AI của mình như thế nào?

Bài viết này sẽ bao gồm khái niệm, các thách thức và lợi ích, và so sánh Serverless GPU với triển khai GPU truyền thống

Serverless GPU Platform Là Gì?

Serverless GPU platform là các dịch vụ đám mây cho phép người dùng truy cập sức mạnh tính toán GPU mà không cần quản lý bất kỳ cơ sở hạ tầng vật lý nền tảng nào. Người dùng có thể triển khai các chức năng nhất định bằng mã (chẳng hạn như yêu cầu HTTP, tải tệp lên hoặc truy vấn cơ sở dữ liệu), và những sự kiện này sẽ kích hoạt môi trường serverless khởi tạo lượng sức mạnh GPU cần thiết mà không cần bất kỳ sự can thiệp nào từ phía người dùng.

Các trường hợp sử dụng hàng đầu cho các nền tảng Serverless GPU bao gồm đào tạo mô hình học máy, phân tích dữ liệu quy mô lớn, suy luận (inference) theo thời gian thực và theo lô, tính toán hiệu năng cao (HPC), và kết xuất/trực quan hóa nội dung.

Tìm hiểu thêm: Multi-GPU Computing: Khái Niệm, Lợi Ích và Cơ Chế Hoạt Động

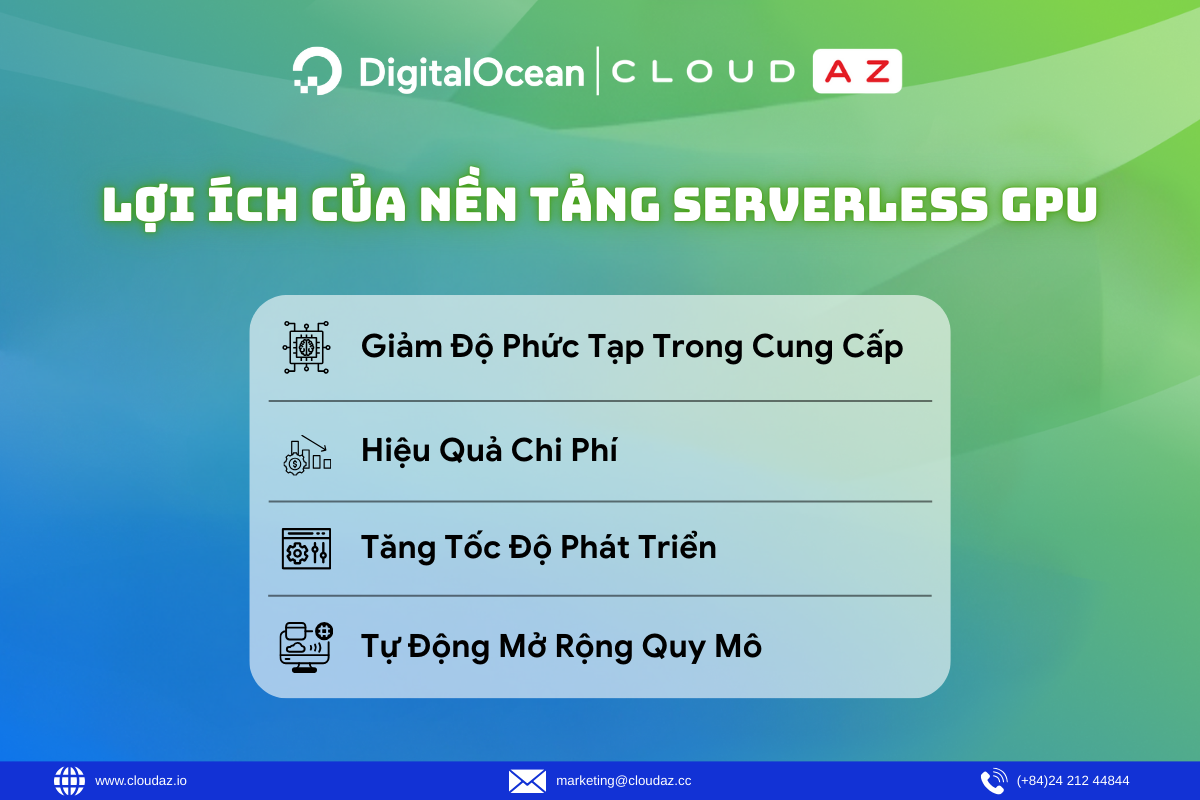

Lợi Ích Của Nền Tảng Serverless GPU

Do không cần cấu hình thủ công cơ sở hạ tầng GPU hoặc cung cấp bảo trì thường xuyên, những lợi ích chính của việc sử dụng Serverless GPU bao gồm:

Giảm Độ Phức Tạp Trong Cung Cấp: Các nền tảng Serverless loại bỏ nhu cầu quản lý thủ công các container, máy ảo (VM), hạn ngạch GPU, hoặc bất kỳ cơ sở hạ tầng hỗ trợ nào để xử lý các tác vụ AI dựa trên GPU.

Hiệu Quả Chi Phí: Người dùng chỉ bị tính phí cho sức mạnh xử lý thực tế được sử dụng, thay vì phải trả tiền liên tục cho các GPU luôn hoạt động. Nền tảng Serverless GPU tự động mở rộng về 0 khi không sử dụng và khởi động lại để hỗ trợ một chức năng cụ thể.

Tăng Tốc Độ Phát Triển: Hầu hết các nền tảng đều cung cấp SDK, tích hợp Git và API đơn giản, cho phép lặp lại và triển khai nhanh chóng. Điều này giúp các nhà phát triển giảm thời gian phát triển và thời gian đưa các sản phẩm phần mềm AI ra thị trường.

Tự Động Mở Rộng Quy Mô (Autoscaling): Các nền tảng tự động tăng hoặc giảm lượng sức mạnh xử lý GPU cần thiết theo nhu cầu, loại bỏ yêu cầu mở rộng quy mô thủ công.

Thách Thức Và Hạn Chế Của Serverless GPU

Mặc dù các nền tảng Serverless GPU giúp việc truy cập sức mạnh tính toán GPU trở nên dễ dàng hơn trong một số trường hợp, các tổ chức vẫn cần cân nhắc một số yếu tố trước khi làm việc với chúng. Các hạn chế tiềm ẩn bao gồm:

Khởi Động Lạnh (Cold Starts): Đối với khối lượng công việc AI, GPU có thể mất thời gian để khởi động sau khi được cung cấp để thiết lập trình điều khiển/plugin CUDA, tải bộ nhớ cache, trọng số mô hình và biên dịch engine. Điều này có thể làm tăng độ trễ và thời gian truy cập GPU.

Tính Sẵn Có Của GPU: Tùy thuộc vào nhà cung cấp dịch vụ đám mây, người dùng có thể gặp phải hạn ngạch GPU hoặc không có các loại GPU cụ thể trong các khu vực trung tâm dữ liệu nhất định, điều này có thể giới hạn nơi khối lượng công việc có thể chạy hoặc lượng sức mạnh GPU có thể được truy cập.

Khó Khăn Trong Khắc Phục Sự Cố: Các nền tảng Serverless GPU trừu tượng hóa các chi tiết cơ sở hạ tầng, khiến việc khắc phục sự cố trở nên thách thức hơn. Khi các vấn đề xảy ra với hiệu suất mô hình, mức sử dụng bộ nhớ hoặc các vấn đề triển khai, người dùng có khả năng hiển thị hạn chế vào môi trường GPU nền tảng.

Biến Động Về Hiệu Suất: Vì người dùng không nhất thiết kiểm soát được phần cứng cụ thể nào được sử dụng mỗi khi chạy khối lượng công việc Serverless GPU, họ có thể gặp phải hiệu suất khác nhau dựa trên phần cứng có sẵn từ nhà cung cấp dịch vụ đám mây.

Serverless GPU so với Triển Khai GPU Truyền Thống

Việc chọn thiết lập GPU phù hợp có thể cần thời gian nghiên cứu. Serverless GPU có thể không phải là lựa chọn tối ưu, tùy thuộc vào yêu cầu khối lượng công việc AI, thiết lập cơ sở hạ tầng hiện tại, ngân sách, và các quy định ngành cần tuân thủ.

Serverless GPU: Được thiết kế tốt cho các khối lượng công việc AI năng động, đòi hỏi khả năng mở rộng liên tục và truy cập vào bộ xử lý hiệu suất cao. Giải pháp này loại bỏ nhu cầu bảo trì cơ sở hạ tầng GPU thủ công. Serverless GPU mang lại khả năng mở rộng và tính linh hoạt để thay đổi phần cứng xử lý khi các yêu cầu kinh doanh hoặc khối lượng công việc thay đổi theo thời gian.

Triển Khai GPU Truyền Thống: Phù hợp với các khối lượng công việc tĩnh hơn, có thể yêu cầu sức mạnh tính toán GPU chuyên dụng, đơn lẻ. Các triển khai này cũng cho phép truy cập trực tiếp vào phần cứng, điều này có lợi nếu người dùng cần thiết lập phần cứng tùy chỉnh cao hoặc cần truy cập nhất quán vào các GPU cụ thể. Việc sử dụng thiết lập GPU truyền thống cung cấp khả năng tùy chỉnh cao hơn, quyền truy cập vào cơ sở hạ tầng riêng và sức mạnh tính toán GPU chuyên dụng nhất quán.

Dịch Vụ Serverless GPU Của DigitalOcean

Các dịch vụ Serverless GPU của DigitalOcean được cung cấp thông qua nền tảng DigitalOcean Gradient™ AI Agentic Cloud, mang đến nhiều lựa chọn đa dạng tùy thuộc vào mức độ kiểm soát và tùy chỉnh mà người dùng mong muốn đối với quy trình làm việc suy luận AI của mình.

Nền tảng Gradient AI cung cấp khả năng tích hợp nguồn tri thức tùy chỉnh, khả năng truy xuất nguồn gốc và quản lý phiên bản, cùng với các tính năng suy luận phi máy chủ như truy cập mô hình hợp nhất, tự động điều chỉnh quy mô, và khả năng kết nối với các mô hình từ Anthropic, OpenAI và Meta. Người dùng cũng có thể truy cập vào kho hướng dẫn rộng lớn của DigitalOcean để giúp họ bắt đầu phát triển ứng dụng AI và tìm hiểu cách triển khai các khối lượng công việc Serverless GPU một cách nhanh chóng.

Các Loại GPU Sẵn Có:

- NVIDIA: RTX 4000 Ada Generation, RTX 6000 Ada Generation, L40S, HGX H100, HGX H200.

- AMD: Instinct™ MI300X, MI325X.

Định Giá: Dịch vụ hoạt động trên mô hình dựa trên mức sử dụng (Usage-based)

Tìm hiểu thêm: Serverless Inference Là Gì? Khai Thác Mô Hình AI Không Cần Quản Lý Máy Chủ

Liên hệ ngay với CloudAZ để nhận tư vấn 1:1 chuyên sâu cùng đội ngũ chuyên gia của chúng tôi giúp doanh nghiệp của bạn phát triển với hiệu suất và khả năng mở rộng vượt trội của Serverless GPU DigitalOcean.