Việc huấn luyện mô hình AI, xử lý các bài toán thị giác máy tính hay vận hành ứng dụng thời gian thực đều đòi hỏi năng lực GPU mạnh mẽ—một khoản đầu tư mà nhiều doanh nghiệp khó có thể tự trang bị. Trong khi đó, các nhà cung cấp đám mây lớn thường định giá dịch vụ cloud GPU ở mức cao, có thể nhanh chóng làm cạn ngân sách, thậm chí lên đến hàng triệu đô la mỗi tháng đối với các cấu hình hiệu năng cao. Thực tế về chi phí này tạo ra rào cản đáng kể cho startup phát triển sản phẩm AI, các nhà nghiên cứu thực hiện dự án tính toán chuyên sâu, cũng như những đội nhóm nhỏ xây dựng từ hệ thống tự hành đến ứng dụng AI tạo sinh. Chỉ riêng một lần huấn luyện mô hình ngôn ngữ lớn hoặc hệ thống thị giác máy tính đã có thể tiêu tốn hàng tuần GPU, kéo theo chi phí mà nhiều tổ chức khó có thể gánh vác.

May mắn thay, sự xuất hiện của các dịch vụ cloud GPU chuyên biệt với mức giá hợp lý đang thay đổi cục diện. Những nền tảng này cung cấp quyền truy cập vào phần cứng cấp doanh nghiệp—bao gồm các GPU NVIDIA H100, H200, A100 và dòng RTX—với chi phí thấp hơn đáng kể so với nhà cung cấp truyền thống. Việc hiểu rõ đâu là dịch vụ mang lại sự cân bằng tốt nhất giữa hiệu năng, độ tin cậy và giá thành có thể quyết định việc một dự án AI được triển khai thành công hay bị đình trệ vì hạn chế tài nguyên tính toán.

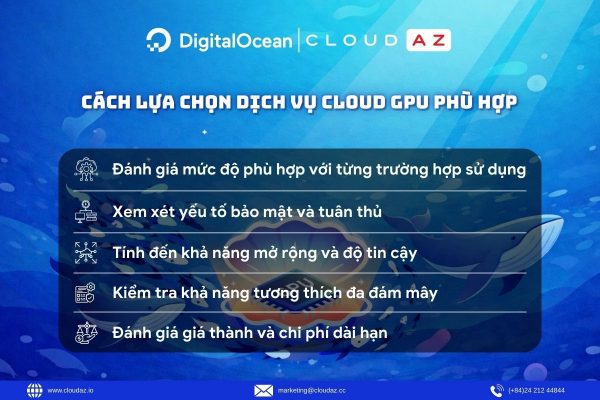

Cách lựa chọn dịch vụ cloud GPU phù hợp

Việc chọn đúng dịch vụ cloud GPU đòi hỏi đánh giá cẩn trọng. Nhà cung cấp đó có thể mở rộng cùng đội ngũ khi chuyển từ giai đoạn thử nghiệm sang sản xuất không? Chi phí tính toán có còn trong tầm kiểm soát nếu quá trình huấn luyện kéo dài hơn dự kiến? Liệu có bị “khóa chặt” vào các công cụ độc quyền khiến việc chuyển đổi nhà cung cấp sau này trở nên phức tạp? Quyết định này ảnh hưởng trực tiếp đến tiến độ dự án và chi phí vận hành dài hạn. Dưới đây là những yếu tố cần cân nhắc:

Đánh giá mức độ phù hợp với từng trường hợp sử dụng

Không phải dịch vụ cloud GPU nào cũng phù hợp cho mọi bài toán. Một nền tảng lý tưởng cho huấn luyện mô hình ngôn ngữ lớn có thể quá dư thừa và tốn kém cho phân loại hình ảnh thời gian thực. Huấn luyện mô hình học máy thường cần GPU dung lượng bộ nhớ lớn và năng lực tính toán cao, trong khi tác vụ suy luận (inference) lại ưu tiên độ trễ thấp và chi phí trên mỗi dự đoán. Khi xác định rõ nhu cầu, doanh nghiệp có thể lựa chọn dịch vụ phù hợp nhất.

Xem xét yếu tố bảo mật và tuân thủ

Bảo mật không chỉ dừng lại ở mã hóa dữ liệu cơ bản, đặc biệt với startup xử lý dữ liệu nhạy cảm hoặc hoạt động trong ngành có yêu cầu pháp lý nghiêm ngặt. Nên ưu tiên dịch vụ cloud GPU cung cấp mã hóa dữ liệu khi lưu trữ và truyền tải, cô lập mạng qua VPC, xác thực đa yếu tố và kiểm toán bảo mật định kỳ bởi bên thứ ba. Đánh giá toàn diện cần bao gồm cơ chế bảo vệ dữ liệu, khả năng cô lập mạng, kiểm soát truy cập và các chứng chỉ tuân thủ.

Tính đến khả năng mở rộng và độ tin cậy

Cần xem xét tốc độ khởi tạo thêm GPU trong các đợt huấn luyện cao điểm, vị trí trung tâm dữ liệu phục vụ tính toán phân tán hoặc triển khai mô hình toàn cầu, cũng như mức giá theo giờ khi mở rộng từ GPU đơn lẻ sang cụm nhiều node. Ngoài ra, nên kiểm tra lịch sử uptime, cách xử lý khi phần cứng gặp sự cố giữa chừng và khả năng tự động chuyển đổi (failover) sang loại GPU hoặc khu vực khác.

Kiểm tra khả năng tương thích đa đám mây

Tính tương thích đa đám mây là yếu tố then chốt với các khối lượng công việc GPU nặng. Điều này giúp tránh phụ thuộc nhà cung cấp và tối ưu chi phí bằng cách phân bổ huấn luyện và suy luận trên nhiều dịch vụ cloud GPU khác nhau theo giá và mức sẵn sàng. Cần đánh giá khả năng hỗ trợ Docker, Kubernetes để triển khai nhất quán, tương thích với các framework phổ biến như TensorFlow, PyTorch, CUDA, và khả năng di chuyển dữ liệu lớn, checkpoint mô hình giữa các môi trường mà không gây tắc nghẽn hiệu năng.

Đánh giá giá thành và chi phí dài hạn

Không nên chỉ nhìn vào giá GPU theo giờ. Cần tính đến chi phí tải lên bộ dữ liệu huấn luyện, tải xuống mô hình đã huấn luyện, lưu trữ checkpoint trong các phiên huấn luyện dài ngày và các gói hỗ trợ cao cấp. GPU dạng spot có chi phí thấp nhưng có thể bị gián đoạn; GPU đặt trước giúp cố định giá nếu nhu cầu sử dụng thường xuyên. Phí truyền dữ liệu có thể tăng nhanh khi di chuyển tập dữ liệu lớn hoặc trọng số mô hình, và lưu trữ bền vững là yếu tố không thể thiếu cho dữ liệu huấn luyện, checkpoint và nhật ký thí nghiệm.

Ưu và nhược điểm khi sử dụng dịch vụ cloud GPU

Các dịch vụ cloud GPU ngày càng trở thành lựa chọn ưu tiên nhờ khả năng khởi tạo hạ tầng mạnh mẽ chỉ trong vài phút, cho phép thử nghiệm linh hoạt mà không cần đầu tư ban đầu lớn, đồng thời dễ dàng mở rộng hoặc thu hẹp theo nhu cầu thực tế. Tuy nhiên, cũng như bất kỳ giải pháp công nghệ nào, cloud GPU đi kèm những đánh đổi mà doanh nghiệp cần cân nhắc kỹ lưỡng trước khi triển khai.

Ưu điểm

Giảm chi phí đầu tư ban đầu

Dịch vụ cloud GPU loại bỏ nhu cầu đầu tư phần cứng quy mô lớn, giúp startup và đội ngũ có nguồn vốn hạn chế vẫn tiếp cận được năng lực tính toán tiên tiến cho AI, machine learning và các khối lượng công việc chuyên sâu.

Tiếp cận phần cứng GPU mới nhất

Các nhà cung cấp cloud thường xuyên nâng cấp danh mục GPU, mang đến khả năng sử dụng những bộ xử lý hiện đại như NVIDIA H200, AMD MI325X và nhiều dòng GPU cao cấp khác—mà không phải trải qua quy trình mua sắm, triển khai và bảo trì phức tạp như hạ tầng vật lý.

Triển khai toàn cầu, độ trễ thấp

Khối lượng công việc có thể được triển khai trên nhiều khu vực địa lý khác nhau, giúp phục vụ người dùng cuối với độ trễ mạng tối thiểu. Đồng thời, mô hình này còn hỗ trợ chiến lược dự phòng thảm họa và tận dụng chênh lệch giá giữa các khu vực.

Nhược điểm

Chi phí vận hành dài hạn có thể cao

Mặc dù mức giá theo giờ của dịch vụ cloud GPU có vẻ hợp lý, việc sử dụng liên tục trong thời gian dài có thể dẫn đến hóa đơn hàng tháng đáng kể, đặc biệt với các tác vụ huấn luyện mô hình kéo dài.

Nguy cơ phụ thuộc nhà cung cấp

Việc tích hợp sâu với các dịch vụ, API và công cụ đặc thù của từng nền tảng cloud có thể tạo ra chi phí chuyển đổi cao, làm giảm khả năng thương lượng và linh hoạt khi muốn thay đổi nhà cung cấp trong tương lai.

Thách thức về bảo mật và tuân thủ

Lưu trữ dữ liệu nhạy cảm và vận hành khối lượng công việc quan trọng trên hạ tầng bên thứ ba đòi hỏi quản trị chặt chẽ các cơ chế mã hóa, kiểm soát truy cập, khung tuân thủ và yêu cầu về chủ quyền dữ liệu. Điều này làm gia tăng độ phức tạp trong vận hành và quản lý rủi ro.

Các nhà cung cấp dịch vụ cloud GPU giá hợp lý

Khi ngân sách còn hạn chế—và thực tế là phần lớn startup đều ở trong tình huống này—việc tìm được điểm cân bằng giữa hiệu năng và chi phí trở nên đặc biệt quan trọng. Dưới đây là một số dịch vụ cloud GPU có mức giá phải chăng, đáng để doanh nghiệp và đội ngũ kỹ thuật cân nhắc:

DigitalOcean Gradient GPU Droplets

DigitalOcean mang đến một giải pháp cloud GPU được thiết kế tinh gọn, với mô hình giá minh bạch và hạ tầng tập trung vào nhu cầu của nhà phát triển. Gradient GPU Droplets cung cấp bộ tăng tốc AMD Instinct MI300X cho các khối lượng công việc AI hiệu năng cao, đồng thời hỗ trợ GPU NVIDIA H100/A100 cho các tác vụ huấn luyện và deep learning. Hệ sinh thái Gradient còn bao gồm các cấu hình GPU bare metal, phù hợp với những trường hợp cần phần cứng chuyên dụng, không chịu overhead của ảo hóa.

Tính năng nổi bật:

- Lựa chọn đa dạng GPU, bao gồm NVIDIA H200, H100, L40S, dòng RTX và AMD Instinct MI300X, MI325X

- Khởi tạo GPU chỉ trong dưới 60 giây với CUDA, PyTorch, TensorFlow và môi trường Jupyter được cài sẵn

- Kết nối trực tiếp với DigitalOcean Managed Databases, lưu trữ Spaces và Load Balancers thông qua mạng riêng

- Bảng điều khiển giám sát tài nguyên tích hợp, cảnh báo chi phí tự động và hạ tầng quản lý theo hướng API-first

- Độ tin cậy cấp doanh nghiệp trên hạ tầng bảo mật cao, đi kèm hỗ trợ kỹ thuật 24/7

Phù hợp nhất cho:

- Đội ngũ phát triển cần triển khai GPU nhanh chóng mà vẫn đảm bảo hiệu năng

- Doanh nghiệp mong muốn một nền tảng cloud tích hợp toàn diện với năng lực GPU hàng đầu

RunPod

RunPod vận hành một nền tảng cloud GPU phân tán, mang lại lợi thế chi phí rõ rệt so với các nhà cung cấp đám mây doanh nghiệp truyền thống. Nền tảng này được xây dựng theo mô hình triển khai dựa trên container, cho phép thử nghiệm nhanh và phân bổ tài nguyên linh hoạt. Người dùng có thể truy cập GPU theo nhu cầu thông qua giao diện web đơn giản, với cả hai tùy chọn serverless và pod chuyên dụng.

Tính năng nổi bật:

- Hệ thống điều phối tích hợp sẵn, hỗ trợ giám sát thời gian thực, logging, cùng cơ chế tự động xếp hàng và phân phối tác vụ

- Danh mục GPU đa dạng, từ GPU phổ thông đến phần cứng cấp doanh nghiệp

- Mẫu triển khai dựng sẵn và hỗ trợ Docker container, giúp đơn giản hóa quá trình triển khai

Phù hợp nhất cho:

- Nhà nghiên cứu AI thực hiện nhiều thử nghiệm song song

- Startup có ngân sách hạn chế

- Lập trình viên cần quyền truy cập GPU linh hoạt trong ngắn hạn

TensorDock

TensorDock tập trung chuyên sâu vào hạ tầng cho machine learning, với các hệ thống được thiết kế riêng nhằm tối ưu cho framework deep learning và khối lượng công việc AI. Nền tảng này cung cấp cả máy chủ bare metal lẫn cloud instance được cấu hình chuyên biệt để đạt hiệu năng ML tối ưu. Bằng cách loại bỏ những lớp overhead không cần thiết thường gặp ở các nền tảng cloud đa mục đích, TensorDock giúp cải thiện đáng kể hiệu suất và hiệu quả chi phí cho dịch vụ cloud GPU.

Tính năng nổi bật:

- Tùy chọn bare metal và cloud instance, đáp ứng đa dạng yêu cầu về hiệu năng

- Quy trình triển khai tinh gọn, được thiết kế riêng cho các tác vụ AI và machine learning

- Quyền truy cập SSH trực tiếp và đặc quyền root, mang lại mức độ tùy biến tối đa

Phù hợp nhất cho:

- Nhà nghiên cứu machine learning và các startup AI

- Đội ngũ cần hiệu năng bare metal thực thụ

- Tổ chức ưu tiên tối ưu hóa chuyên sâu cho ML hơn là các dịch vụ cloud tổng quát

CoreWeave

CoreWeave vận hành hạ tầng cloud GPU chuyên biệt, được thiết kế dành riêng cho các khối lượng công việc AI và tính toán hiệu năng cao (HPC). Nền tảng này sở hữu kiến trúc tối ưu cho các ứng dụng tăng tốc bằng GPU, thay vì phục vụ các tác vụ tính toán tổng quát như nhiều nền tảng cloud truyền thống.

Tính năng nổi bật:

- Không tính phí dữ liệu vào và ra, giúp loại bỏ các chi phí truyền dữ liệu ẩn

- Quản lý vòng đời và sức khỏe cụm GPU tự động, đảm bảo tính ổn định trong quá trình vận hành

- Hệ thống mạng hiệu năng cao được thiết kế riêng cho các cụm GPU

Phù hợp nhất cho:

- Doanh nghiệp có nhu cầu GPU biến động, các tác vụ render và mô phỏng

- Công ty AI cần năng lực tính toán hiệu năng cao mà không phải lo ngại chi phí truyền dữ liệu

Lambda Labs

Lambda Labs tập trung chuyên biệt vào hạ tầng deep learning, phục vụ trực tiếp nhu cầu của cộng đồng nghiên cứu AI. Nền tảng này thường xuyên cung cấp quyền truy cập sớm vào các thế hệ GPU mới nhất, thậm chí triển khai trước cả nhiều nhà cung cấp cloud quy mô lớn. Bên cạnh đó, Lambda Labs còn cung cấp các môi trường phần mềm được cấu hình sẵn, tối ưu cho những framework machine learning phổ biến, giúp rút ngắn thời gian triển khai dịch vụ cloud GPU.

Tính năng nổi bật:

- Truy cập Jupyter Notebook chỉ với một cú nhấp trực tiếp trên trình duyệt

- Cung cấp cả tùy chọn hạ tầng cloud và phần cứng on-premise, đáp ứng đa dạng nhu cầu triển khai

- Cloud API thân thiện với lập trình viên, cho phép quản lý instance theo cách lập trình hóa

Phù hợp nhất cho:

- Nhà nghiên cứu AI cần phần cứng tiên tiến, cập nhật sớm

- Startup ưu tiên hiệu năng tính toán hơn yếu tố chi phí

- Đội ngũ cần quyền truy cập ổn định vào các công nghệ GPU mới nhất

Cách tránh các chi phí ẩn khi sử dụng dịch vụ cloud GPU

Khối lượng công việc GPU có nhiều đặc thù dễ khiến doanh nghiệp “bất ngờ” khi nhận hóa đơn. Chi phí của dịch vụ cloud GPU thường tăng theo cách khác so với compute thông thường, đặc biệt liên quan đến dung lượng bộ nhớ, yêu cầu phần cứng chuyên biệt và cơ chế tính phí. Dưới đây là những chiến lược giúp kiểm soát và hạn chế các khoản chi phí phát sinh ngoài dự kiến.

Chiến lược tối ưu chi phí GPU

- Lựa chọn GPU có dung lượng VRAM phù hợp ngay từ đầu để tránh tình trạng hoán đổi bộ nhớ tốn kém hoặc phải khởi tạo nhiều GPU khi chỉ cần một GPU lớn hơn.

- Áp dụng nén mô hình và kỹ thuật quantization nhằm giảm nhu cầu bộ nhớ, từ đó có thể sử dụng các tùy chọn GPU có chi phí thấp hơn.

- Lưu trữ dữ liệu đã tiền xử lý và các checkpoint mô hình ở định dạng mà GPU có thể truy xuất nhanh, tránh việc GPU phải chờ dữ liệu trong khi vẫn bị tính phí cao.

- Thiết kế pipeline dữ liệu để tải trước batch tiếp theo khi GPU vẫn đang xử lý batch hiện tại, giúp tối đa hóa thời gian GPU thực sự làm việc.

Giám sát và kiểm soát chi tiêu GPU

- Thiết lập cảnh báo khi mức sử dụng bộ nhớ GPU thường xuyên dưới 70%, từ đó cân nhắc chuyển sang cấu hình GPU nhỏ hơn và tiết kiệm chi phí.

- Theo dõi tiến độ các job huấn luyện để phát hiện sớm những mô hình phù hợp hơn với huấn luyện phân tán trên nhiều GPU nhỏ, rẻ hơn thay vì một GPU cao cấp duy nhất.

- Tự động dừng các phiên huấn luyện không còn cải thiện kết quả, tránh chi phí phát sinh do chạy kéo dài không hiệu quả.

Tối đa hóa hiệu quả ngân sách GPU

- Sử dụng huấn luyện mixed-precision để giảm nhu cầu băng thông bộ nhớ và cho phép chạy trên các cấu hình GPU nhỏ hơn.

- Tối ưu batching cho các tác vụ inference, khai thác tối đa mỗi giờ GPU đã trả phí.

- Chạy đồng thời nhiều mô hình nhỏ trên cùng một GPU cao cấp thay vì khởi tạo nhiều instance riêng lẻ.

- Tăng tốc thời gian tải mô hình để giảm thời gian chờ đợi bị tính phí trước khi công việc thực sự bắt đầu.

Tự động hóa thông minh cho GPU

- Tận dụng GPU dạng spot hoặc preemptible kết hợp với cơ chế checkpoint, cho phép tiếp tục công việc khi instance bị thu hồi.

- Xây dựng các pool GPU có khả năng chuyển đổi linh hoạt giữa các loại phần cứng dựa trên yêu cầu cụ thể của từng tác vụ.

- Lên lịch chạy các job GPU vào khung giờ thấp điểm, khi chi phí rẻ hơn, nếu điều kiện cho phép.

- Thiết kế pipeline tự động nén mô hình trước khi triển khai, giúp duy trì chi phí vận hành và hosting ở mức hợp lý trong dài hạn.

Tăng tốc các dự án AI với DigitalOcean Gradient GPU Droplets

DigitalOcean Gradient GPU Droplets giúp tăng tốc mạnh mẽ các tác vụ AI/ML, deep learning, tính toán hiệu năng cao (HPC) và phân tích dữ liệu. Nền tảng dịch vụ cloud GPU này cho phép mở rộng linh hoạt theo nhu cầu, kiểm soát chi phí hiệu quả và nhanh chóng chuyển hóa dữ liệu thành insight giá trị. Chỉ với 2 cú nhấp, người dùng có thể sẵn sàng GPU ngay lập tức thông qua các máy ảo đơn giản nhưng mạnh mẽ—được thiết kế dành cho nhà phát triển, startup và các tổ chức đổi mới cần năng lực tính toán cao mà không phải đối mặt với sự phức tạp không cần thiết.

Tính năng nổi bật:

- Vận hành trên các GPU hàng đầu như NVIDIA H100, H200, RTX 6000 Ada, L40S và AMD MI300X

- Tiết kiệm đến 75% chi phí so với các hyperscaler khi sử dụng GPU on-demand tương đương

- Cấu hình linh hoạt, từ GPU đơn lẻ đến hệ thống 8 GPU

- Cài sẵn Python và các bộ phần mềm deep learning phổ biến, sẵn sàng cho triển khai ngay

- Bao gồm ổ đĩa boot và scratch local hiệu năng cao

- Đáp ứng tiêu chuẩn HIPAA và các chuẩn tuân thủ ngành, đi kèm SLA cấp doanh nghiệp

Tìm hiểu thêm:

Cloud GPU: TOP 7 Nền tảng tốt nhất cho AI, ML và HPC năm 2026

Edge Computing vs Cloud Computing: Những Khác Biệt Cốt Lõi

Hãy đăng ký ngay hôm nay để khai mở toàn bộ tiềm năng của DigitalOcean Gradient GPU Droplets. Đối với các nhu cầu tùy chỉnh, phân bổ GPU quy mô lớn hoặc mô hình đặt trước (reserved instances), đội ngũ kinh doanh của CloudAZ sẵn sàng tư vấn để giúp doanh nghiệp vận hành hiệu quả những khối lượng công việc AI/ML đòi hỏi cao nhất.